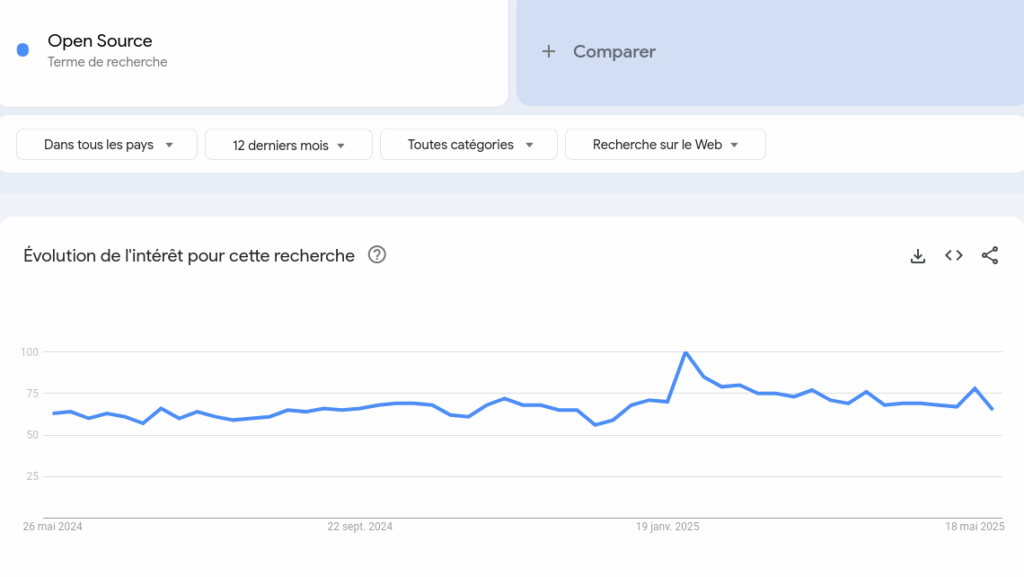

Début 2025, l’Open Source a été au cœur des débats grand public concernant l’Intelligence Artificielle. L’arrivée sur le marché de DeepSeek et de son modèle DeepSeek V3 a été un grand coup de pied dans la fourmilière de l’industrie de l’IA et de ses investisseurs, montrant qu’il était possible de fournir un modèle “ouvert” et à plus faible coût. L’Open Source fait figure de symbole dans ces débats, d’une part celui de la promesse d’une IA éthique et transparente et d’autre part celui d’un « danger mortel » au service du terrorisme. Mais derrière ces positions reflétant des plus grandes craintes aux plus grands espoirs que suscitent l’IA, la définition même d’une IA Open Source demeure floue. Cette question a fait l’objet de vifs débats dans les communautés Open Source notamment autour de la prise de position de l’Open Source Initiative (OSI) face à la mention d’une IA Open Source dans la réglementation européenne (IA ACT). Plus qu’une question de licences à apposer sur un système IA et ses composants (modèles et poids des modèles, données, code source), il est intéressant de faire un pas de côté et de se questionner sur la gouvernance des systèmes d’IA. Le mouvement des communs, avec le regard qu’il porte sur les modes d’organisation des communautés qui prennent soin de ressources partagées, offre des pistes de réflexions fructueuses.

Depuis le lancement (grand public) de ChatGPT en 2022, le terme d’Intelligence Artificielle fait l’objet d’un rebond d’usage. Il est surtout employé aujourd’hui par les médias pour décrire des IA génératives basées sur des modèles de fondation ou plus spécifiquement des LLM (Large Language Models). Si l’IA générative généraliste ChatGPT est toujours en tête des usages en 2025, de nombreux autres outils plus spécialisés se développent (retouche photo, générateur d’images et de vidéos, etc.). Ces outils prennent une place croissante notamment dans les pratiques numériques quotidiennes.

L’usage de l’IA se fait aussi de plus en plus présent dans le monde du travail. Cela amène entreprises et institutions à se positionner sur le développement de leur propre outil d’IA ou bien la mise en place de règles quant à l’usage d’outils proposés sur le marché. Des chartes d’utilisation se développent au sein d’entreprises, mais aussi à destination des clients. L’idée est de pouvoir réfléchir au fonctionnement et à l’utilisation de l’IA pour prévenir un certain nombre d’usages abusifs et malveillants en promouvant une « éthique de l’IA ». La transparence, la justice, la non-malfaisance, la privacy sont ainsi mises en avant.

Outre ces régulations à l’œuvre à l’échelle des organisations, les États et instances supra-étatiques tentent de cadrer les usages des IA pour des raisons éthiques, mais aussi commerciales et de sécurité. Il n’est en effet pas neutre que des milliers de données de différents usagers autour du monde puissent servir à entrainer des modèles nord-américains ou chinois. L’ensemble des directives européennes mises en œuvre depuis 2023 autour des données (Data Act), des services numériques (Digital Service Act) et de l’IA (AI Act) montre la volonté d’apporter une régulation des ressources informationnelles numériques sur le marché de l’Union Européenne, et assurer au mieux une souveraineté numérique pour l’Europe.

Une IA « ouverte » au cœur des débats médiatiques

Le développement d’une IA ouverte, inclusive et éthique a dans ce sens été mis en avant comme solution pour lutter contre la domination des marchés nord américains lors du sommet pour l’IA à Paris en 2025. Dans le règlement européen sur l’IA publié en 2024, dont la vocation est d’apporter un cadre réglementaire et juridique aux usages de l’IA en Europe, on retrouve également la notion de composants IA Open Source (Open Source AI components1). Le document propose une classification des systèmes d’IA en fonction de différents niveaux de risques (inacceptable, haut risque, etc.) avec un ensemble d’exigences et d’obligations pour les fournisseurs qui leurs sont associés. Dans le cas de modèles IA – notamment des General Purpose AI — sous licences libres ou Open Source, les contraintes et obligations seraient allégées2.

Mais qu’entend-on par une IA ouverte ou des composants IA Open Source ? Le nom de l’entreprise ayant fait connaitre l’IA générative avec son outil ChatGPT montre bien que « l’ouverture » est avant tout un argument de vente. Open AI, précédemment entreprise à mission, proposait ses premiers modèles de GPT avec des poids ouverts (open weight) mais ce fut rapidement refermé3.

L’arrivée de DeepSeek en janvier 2025, en se positionnant comme une IA Open Source, a remis au centre l’Open Source, comme une pression concurrentielle pour le développement d’IA et pour se démarquer de ses voisins.

Si l’on creuse un peu, on se rend compte que même DeepSeek, alors associé dans les discours à l’Open Source, sort des critères d’une IA Open Source selon l’Open Source Initiative, qui a fait un important et périlleux travail de définition collective d’une IA Open Source.

Une IA Open Source ? Une première définition par l’OSI

La publication de l’IA Act et, plus globalement, la tendance à qualifier d’ « ouvert » un bon nombre de modèles d’IA, a poussé l’OSI (Open Source Initiative) à se positionner et à proposer une définition d’une IA Open Source (OSAID) en 2024. Des travaux antérieurs avaient déjà été menés par d’autres organismes (Mozilla, Linux Foundation, etc.).4 Mais l’OSI en tant que garant de la définition de l’Open Source avait un rôle particulièrement important à jouer.

Un processus consultatif (co-design) a ainsi été mis en place entre 2023 et 2024. Le choix a été fait de s’appuyer sur les critères de l’Open Source (utilisation, inspection, modification, partage) et de les appliquer au modèle d’IA. La définition Open Source de l’IA demande ainsi un accès au code source complet du modèle (entrainement et exécution), ainsi qu’aux paramètres et poids du modèle et aux informations sur les données. Néanmoins, les données qui ont permis l’entrainement des modèles n’ont pas à être accessibles, ce qui a mené à de nombreux débats. Ce choix est notamment justifié par l’OSI comme volonté de ne pas reléguer la définition Open Source a une infime partie des modèles IA dont l’entièreté des données d’entraînements seraient en open data. En pratique, certaines données peuvent servir de données d’entraînement, mais ne peuvent être légalement partagées (données de santé par exemple). Cette exclusion favoriserait donc l’innovation en Open Source, même dans des domaines, où les données ne sont pas partageables, et laisse le choix aux utilisateurs d’utiliser les données disponibles et ouvertes ou d’en ajouter d’autres non partageables.

Un autre point sujet à discussion a été celui d’associer à la définition des limitations pour garantir une IA responsable ou éthique. Le parti pris a été d’articuler la définition à d’autres recommandations ou principes directeurs déjà existants, par exemple les recommandations du Conseil sur l’intelligence Artificielle de l’OCDE5

Au sujet des données, des travaux complémentaires ont été menés pour questionner la gouvernance des données de l’IA et plus globalement la gouvernance des systèmes d’IA dans une logique de confiance et de transparence.

Gouvernance des données d’entrainement d’un modèle d’IA : l’influence des communs numériques

En parallèle de la définition d’une IA Open Source, l’OSI et Open Future ont entamé une réflexion sur la gouvernance des données dans des IA Open Source donnant lieu à un livre blanc. Plusieurs enjeux associés aux données servant à l’entrainement des modèles IA ont été abordés sous l’angle des communs numériques.

Il est ainsi question de souligner l’extractivisme de données à l’œuvre par quelques acteurs qui ont les capacités humaines et techniques d’extraire puis d’exploiter des données issues du web (open web dans le rapport), menant à un colonialisme de données, c’est-à-dire une privatisation et une dépossession de données issues de communautés ou de citoyen.ne.s par quelques forces en présence. Cela se rapproche de ce qui a été appelé un paradoxe de la disponibilité « open paradox« , autrement dit une existence massive de données issues du web qui nourrissent les modèles d’IA, mais une rareté de données restreintes et propriétaires qui offrent un avantage commercial à ces mêmes modèles.

Pour contrer ces mécanismes de concentration de pouvoir, le rapport souligne qu’un accès à des données de qualité est nécessaire, quelque que soit leur statut (ouverte, partagée sur le web, propriétaire), dans un cadre de gouvernance défini entre plusieurs acteurs hétérogènes. Cette approche par les communs (data commons approach) offre une utilisation maitrisée de ces données et un retour à la communauté. On sort d’un modèle « ouvert » car des restrictions sont possibles, mais elles sont décidées dans la gouvernance. Ce cadre vise à prendre soin des données et de fournir un accès juste et équitable pour la communauté dédiée. Un autre aspect cité et l’importance de favoriser la création d’un écosystème d’acteurs autour de ces données (intendant de contenu, développeurs d’IA) notamment dans une optique de Small Language Model (en opposition aux Large Language models).

Un autre rapport éclairant « Legal frictions for data openness: Reflections from a case-study on re-use of the open web for AI training » apporte une grille d’analyse pour considérer les aspects clefs d’un modèle d’IA préservant l’ethos d’une libre circulation des données juste et équitable.

Un modèle tri dimensionnel est proposé reposant sur

- les aspects technico-juridiques de l’ouverture

- les enjeux de souveraineté des données par les communautés

- les limitations possibles en termes d’extractivisme de données par les BigTech

Par un travail d’analyse de controverses juridiques en cours concernant les droits d’auteur et la protection des données d’entrainement des modèles d’IA, un ensemble de questions sont posées :

- Y a-t-il copie de données issues du web lorsqu’on crée des données d’apprentissage ?

- Est-ce que le scraping est une pratique légale pour constituer des données d’apprentissage ?

- Quel est le statut des résultats d’un modèle, est-ce un produit dérivé ?

Un recensement d’initiatives apportant des réponses ou au moins des pistes de travail est proposé. Un regard critique est porté sur l’inflation de nouvelles licences associées à ces modèles d’IA (OpenRAIL Licences, AI2impact licences, Montreal Licences, Kaitiakitanga licences, etc.). Certaines visent à cadrer l’accès aux données d’entrainement pour contrer aux menaces d’extractivisme ou de perte de souveraineté, mais se pose la question de leur véritable application et impact. Cette réflexion amène à se questionner sur les moyens mis en œuvre pour construire et préserver des modèles d’IA ouverts, éthiques et inclusifs en considérant à la fois les aspects sociaux et techniques de cet ensemble.

Conclusion

Les modèles IA ont remis au centre les questions d’ouverture en tant qu’un des piliers forts contre les menaces que font peser une concentration de pouvoir de ces techniques par quelques entreprises. Face à l’intérêt pour des modèles « ouverts x en termes de contraintes réglementaires allégées et argument de vente, les communautés Open Source et plus globalement d’un internet libre et éthique se sont positionnées pour veiller à la mise en œuvre de modèle respectueux des principes et des valeurs qu’elles portent.

C’est ainsi que l’OSI a proposé un premier jalon avec une première définition suscitant débats et commentaires. La gouvernance des données d’apprentissage est quant à elle été interrogée au prisme des communs numériques.

Le déploiement commercial de modèle d’IA et l’usage massif de ces derniers (notamment des LLMs) amènent à se réinterroger sur les gardes fous nécessaires aux respects des libertés des internautes. Dans l’Open Source, le levier central employé est la propriété intellectuelle de façon à organiser la diffusion de la ressource et sa maintenance.

Aujourd’hui, l’IA vient modifier cet aspect en mettant un coup de projecteur sur les communautés prenant soin de ces briques Open Source. Avec l’automatisation même des tâches de développement par l’IA, la communauté et la gouvernance mise en place vont jouer un rôle majeur. Les réflexions sur des approches en communs autour des données d’entrainement des modèles d’IA soulignent l’importance de considérer les écosystèmes garantissant la confiance en ces modèles d’IA. Ces écosystèmes peuvent se bâtir aussi bien sur la base d’outils de propriété intellectuelle centrés sur les ressources à l’image des licences libres et de libre diffusion déjà existantes ainsi que sur un ensemble de dispositifs supplémentaires sécurisant les communautés et les relations collaboratives qui les unissent.

Notes de bas de page

- « Free and open-source AI components covers the software and data, including models and general purpose AI models, tools, services or processes of an AI system ».Recital 60i:

- « The providers of general purpose AI models that are released under a free and open source license, and whose parameters, including the weights, the information on the model architecture, and the information on model usage, are made publicly available should be subject to exceptions« . Recital 60f:

- GPT2 en 2019 avait partagé les poids de son modèle, c’est-à-dire l’ensemble des paramètres qui sont employés pour entrainer le modèle. https://github.com/openai/gpt-2

- Quelques exemples d’initiatives : the Digital Public Goods Alliance’s standard for AI as a digital public good, the Linux Foundation’s Model Openness Framework (MOF), the Mozilla’s Convening on openness in Artificial Intelligence.

- Section 1 : Principes pour une gestion responsable d’une IA fiable https://legalinstruments.oecd.org/en/instruments/oecd-legal-0449#dates ↩︎